时间:2021-07-31 来源:博客园

Bladed是一个用于风力发电机组性能和载荷仿真计算的建模工具,全球大型风力机制造商约有半数采用该软件。

在风力发电机组的各个设计阶段,优化设计都是重中之重。如果不能正确地对载荷、恶劣环境和结构完整性进行建模,或不能执行准确试验,都可能会极大地危害机组长期的安全性、功能性和盈利能力。

风力机设计项目经常需要进行大量仿真计算,一组仿真计算耗费数千小时的计算机时。

一方面,算力在总量和项目波峰波谷期的弹性供应上能否满足需求。充足的算力意味着缩短产品上市时间,拉大市场优势。

另一方面,超大规模算力的调度使用和企业场景的复杂性带来的管理等问题对IT自动化和智能化要求很高。如何调度超大规模集群的过程,还有其中隐藏的成本优化问题,其实很多。

怎么解决这些问题?

我们拿实证说话。

实证背景信息

某风电新能源集团建设有本地机房,但机器较陈旧,资源有限。跑Bladed仿真任务计算周期长,特别是有大型仿真任务时,往往需要数周甚至数月才能出结果。

用户要求将跑大型任务的时间缩短到一天以内,同时能够对任务进行管理和监控。

实证目标

1、Bladed任务能否在云端有效运行?

2、fastone平台能否将大规模Bladed仿真任务周期缩短到一天?

3、fastone平台能否提供高效灵活的数据传输方案?

4、fastone平台能否提供有效的任务管理和监控?

实证参数

平台:

fastone企业版产品

应用:

Bladed 4.10版

操作系统:

Bladed 4.10之前的版本不支持Linux系统,只支持Windows。

本次实证由于用户更熟悉Windows操作系统,所以并未选择Linux镜像。

主流云厂商对不同操作系统镜像有不同的定价方式。整体上来说,通过Windows系统使用云资源价格比Linux系统要贵。

适用场景:

构建风力发电机性能模型,运行仿真计算并处理结果,为工程师提供有关风力机动力学和优化的重要决策信息。

License配置:

Bladed License Server设置在云端。

云端硬件配置:

Bladed是一个计算密集型应用,对CPU要求高、内存要求不大,因此平台为用户推荐选择了满足其应用特点的计算优化型实例机型。

调度器:

因为选择了Windows操作系统,所以本实证中集群调度使用的是PBS调度器。

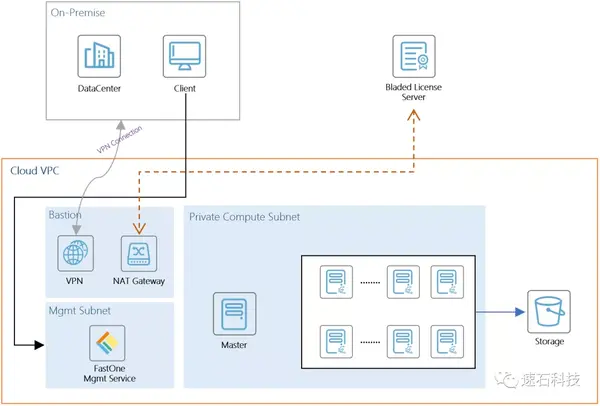

技术架构图:

用户通过Web方式登录构建于公有云上的fastone算力运营平台,根据实际计算需求自动创建、销毁集群,提交计算任务,上传下载任务,监控管理。

用户通过NAT方式访问位于公网的License服务器。

用户通过VPN接入,可更安全地访问云上私密的HPC环境。

实证场景一:大规模业务验证

9600个用例

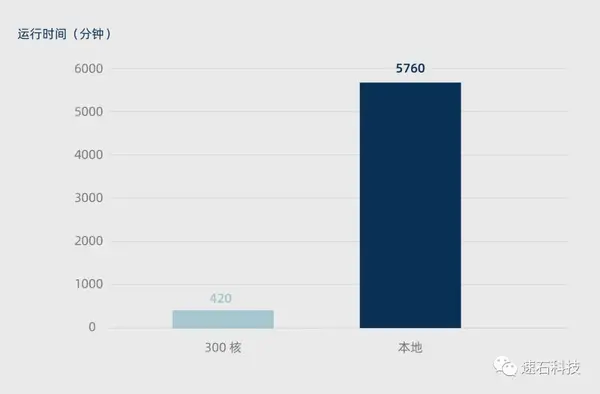

本地VS云端300核

结论:

1、云端可提供满足Bladed应用特点的机型,运行Bladed Windows版本的任务;

2、本地资源运算9600个用例,耗时约4天;通过fastone平台调用300核计算优化型实例运算9600个用例,总耗时约8小时,任务运行时间7小时;

3、fastone平台的自动化伸缩,有效降低整个计算周期资源占用率;

4、fastone平台能提供灵活高效的数据传输方案,满足计算数据量大需求;

5、fastone平台可稳定运行Bladed任务、测试过程中未发生服务中断;

6、fastone平台可监控、管理任务与集群的运行情况。

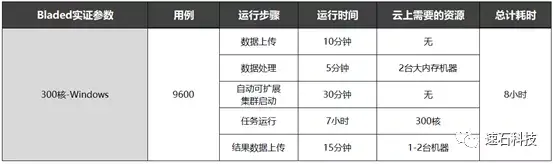

实证过程:

1、数据上传:用户将Bladed风文件、工况文件等上传至fastone平台;

2、数据处理:自动下载、解压数据,修改配置;

3、自动可扩展集群启动:用户选择Bladed 应用,按需构建300个核的Bladed集群;

4、任务运行:提交任务后,用户可随时在监控界面查看任务和集群运行情况;

5、结果数据上传:任务运行成功后,自动将结果数据上传至对象存储供用户下载。

数据传输优化:

Bladed的风文件和任务文件数据量极大,传统传输模式往往会面临以下问题:

1、初始化大文件传输。在本实证中,用户在跑任务之前需要上传多达数百GiB的风文件;

2、随着任务的调整,有大量小文件需要增量上传。在本实证中,用户需要上传9600个任务文件,每个几十MiB不等。

fastone支持全自动化数据上传,可充分利用带宽,帮助用户快速上传、下载海量数据。

同时,利用fastone自主研发的分段上传、高并发、断点续传等数据传输技术,优化海量数据的传输效率。

自动化部署:

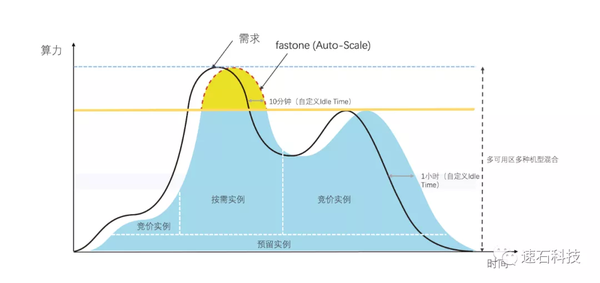

在手动模式下,通常都是先构建一个固定规模的集群,然后提交任务,全部任务结束后,关闭集群。

在本实证中,如果是手动部署,300核的集群一旦拉起,第一到第五步手动配置的时间里,所有机器一直都是开启状态,也就是说,烧钱中。

更详尽的涉云成本计算,可参考:帮助CXO解惑上云成本的迷思,看这篇就够了

再看看我们的自动化部署:

在本实证中,fastone平台在任务的不同阶段采取不同的策略应对,除任务运行的7小时内有300核云资源满负荷运作以外,在数据处理和结果数据上传阶段均只开启了1-2台机器,而其他准备过程不需要开启机器。

很重要的一点是:任务完成后会及时下载结果并自动关机。

fastone的Auto-Scale功能可以自动监控用户提交的任务数量和资源的需求,动态按需地开启所需算力资源,在提升效率的同时有效降低成本。

用户可根据自己需求,设置自动化调度集群规模上下限。

所有操作都是自动化完成,无需用户干预;

在实际开机过程中,可能遇到云在某个可用区资源不足的情况,fastone会自动尝试从别的区域开启资源;

如果需要的资源确实不够,又急需算力完成任务,用户还可以从fastone界面选择配置接近的实例类型来补充。

详细分解手动模式 VS 自动部署,看这里:EDA云实证Vol.1:从30天到17小时,如何让HSPICE仿真效率提升42倍?

任务和集群管理:

提交任务后,可以在监控界面中查看任务和集群运行情况。

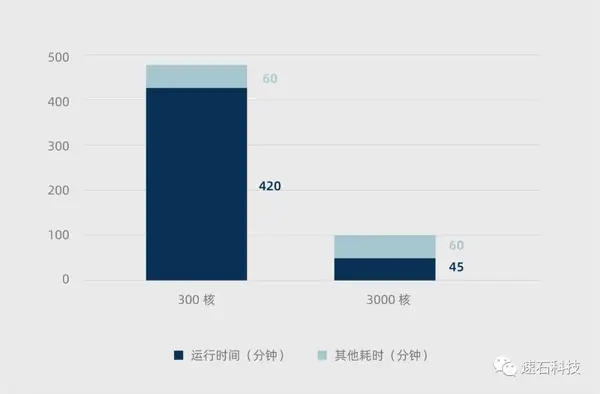

实证场景二:云端线性扩展验证

9600个用例

云端300核 VS 3000核

Bladed应用具备线性扩展性。

当我们把自动化调度集群规模上限设为3000核,任务运行时间从7小时缩短到45分钟,整体计算周期也从8小时缩短至1.75小时。

实证过程:

本实证中,单个任务运行时间为10-30分钟,当有任务提前运行完成且数据下载完后,相应的机器会自动关闭,避免资源浪费。

实证小结

最后我们回顾一下实证目标:

1、Bladed Windows版本任务在云端能够有效运行;

2、fastone平台成功将大规模Bladed仿真任务的运算时间从4天缩短到1~7小时;

3、fastone平台能够提供灵活高效的数据传输方案;

4、fastone平台能够提供可靠的任务管理和监控。

除了Windows系统,我们还支持通过fastone平台同时调度任务至本地和云上的Windows节点和Linux节点,满足业务需求。同时,我们也支持SLURM/SGE/LSF等主流调度器,本次实证未曾涉及。

本次CAE行业Cloud HPC实证系列Vol.2就到这里了。

在下一期的实证中,我们将利用速石平台,在混合云场景下调度集群运行CAE分析,使LS-DYNA模拟性能得到极大提升。

未来我们还会带给大家更多领域的用云“真香”实证,请保持关注哦!

- END -

来源:博客园

回复: